Wikimedia заключила партнерство с Meta, материнской компанией Facebook, для создания модели искусственного интеллекта (ИИ), которая улучшит проверку фактов. Как пишет «Хайтек», это разгрузит редакторов-волонтеров проекта и улучшит надежность сервиса.

Исследователи объяснили, что по мере роста количества статей в «Википедии» там появляется много ложной или неполной информации, а также все чаще встречаются неточные ссылки. Чтобы решить эту проблему, Meta* разработала модель ИИ, которая автоматически сканирует цитаты, сверяет факты с другими источниками, проверяет ссылки и занимается фактчекингом.

*Meta, в том числе ее продукты Facebook и Instagram, признана экстремистской организацией в России.

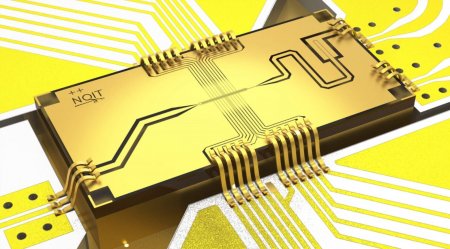

ИИ использует модель преобразования Natural Language Understanding (NLU), которая пытается понять взаимосвязи между словами и фразами в предложении. Индексом знаний модели является база данных Sphere, которая содержит более 134 млн веб-страниц. Кроме того, модель разработана таким образом, чтобы найти единственный источник для проверки каждого утверждения.

В 2020 году Wikimedia начала разработку алгоритма после скандала, когда подросток из США написал 27 999 записей на языке, которым он не владел. Похожая история произошла в 2022 году — жительница Китая создала 206 статей об истории России, выдумывая военные и экономические события, вплетая их в настоящие факты.

Meta начала уже начала разрабатывать основу для инструментов цитирования следующего поколения. В 2021 году компания выпустила модель ИИ, которая объединила поиск и проверку информации. Также ведется обучение нейронных сетей более сложным тонкостям языка для поиска релевантного исходного материала в интернете.

Как только они будут готовы, модели ИИ улучшат качество знаний в «Википедии». Это позволит сохранить точность ресурса, которым пользуется множество людей по всему миру.